Oscar Sainz

@osainz.bsky.social

Postdoctoral Researcher at the University of the Basque Country (UPV/EHU).

Reposted by Oscar Sainz

#Latxa txatbota probatarako erabilgarri jarri dugu! latxa.hitz.eus

Jaso ditugun eskaerei erantzunez zuen eskura jarri dugu Latxaren bertsio ahaltsuena, chatGPT-tik gertu dabilena, baina euskara txukunagoa sortuz.

Jaso ditugun eskaerei erantzunez zuen eskura jarri dugu Latxaren bertsio ahaltsuena, chatGPT-tik gertu dabilena, baina euskara txukunagoa sortuz.

Gradio

Click to try out the app!

latxa.hitz.eus

October 31, 2025 at 6:57 AM

#Latxa txatbota probatarako erabilgarri jarri dugu! latxa.hitz.eus

Jaso ditugun eskaerei erantzunez zuen eskura jarri dugu Latxaren bertsio ahaltsuena, chatGPT-tik gertu dabilena, baina euskara txukunagoa sortuz.

Jaso ditugun eskaerei erantzunez zuen eskura jarri dugu Latxaren bertsio ahaltsuena, chatGPT-tik gertu dabilena, baina euskara txukunagoa sortuz.

Reposted by Oscar Sainz

Ayer uno de nuestros investigadores, Oscar Sainz (@osainz.bsky.social), fue galardonado con el premio a la mejor tesis doctoral en Inteligencia Artificial por la Asociación Española para la Inteligencia Artificial (AEPIA). ¡Enhorabuena! 🥳

July 10, 2025 at 7:25 AM

Ayer uno de nuestros investigadores, Oscar Sainz (@osainz.bsky.social), fue galardonado con el premio a la mejor tesis doctoral en Inteligencia Artificial por la Asociación Española para la Inteligencia Artificial (AEPIA). ¡Enhorabuena! 🥳

Reposted by Oscar Sainz

«Kaixo, Latxa naiz. Zer jakin nahi duzu gaur?». Euskarazko txatbota sortu du EHUko HiTZ ikerketa zentroak. Oraindik ez dute publikora zabaldu, baina garatzaileek eta enpresek eskuratzeko aukera dute. BERRIAko testuak erabili dituzte Latxa entrenatzeko.

t.co/OPVNnBG2xW?utm_...

t.co/OPVNnBG2xW?utm_...

«Kaixo, Latxa naiz. Zer jakin nahi duzu gaur?»

Euskarazko txatbota sortu du EHUko HiTZ ikerketa zentroak. Oraindik ez dute jendaurrean zabaldu, baina garatzaileek eta enpresek eskuratzeko aukera dute. BERRIAko testuak erabili dituzte Latxa entr...

t.co

June 16, 2025 at 9:00 PM

«Kaixo, Latxa naiz. Zer jakin nahi duzu gaur?». Euskarazko txatbota sortu du EHUko HiTZ ikerketa zentroak. Oraindik ez dute publikora zabaldu, baina garatzaileek eta enpresek eskuratzeko aukera dute. BERRIAko testuak erabili dituzte Latxa entrenatzeko.

t.co/OPVNnBG2xW?utm_...

t.co/OPVNnBG2xW?utm_...

Do you know that you can continue pretraining Instructed LLMs without losing their instruction following capabilities?

We did so to teach Basque to Llama models with promising results!

Interestingly, you only need English instructions and target language corpora 🤯

1/3

We did so to teach Basque to Llama models with promising results!

Interestingly, you only need English instructions and target language corpora 🤯

1/3

[4/7]

Key findings:

1️⃣Language corpora is essential: models need exposure to plain Basque text

2️⃣Starting from instructed models beats the standard base→instruct pipeline

3️⃣English-only instructions work well, but combining with Basque instructions yields the most robust models

Key findings:

1️⃣Language corpora is essential: models need exposure to plain Basque text

2️⃣Starting from instructed models beats the standard base→instruct pipeline

3️⃣English-only instructions work well, but combining with Basque instructions yields the most robust models

June 11, 2025 at 6:01 PM

Do you know that you can continue pretraining Instructed LLMs without losing their instruction following capabilities?

We did so to teach Basque to Llama models with promising results!

Interestingly, you only need English instructions and target language corpora 🤯

1/3

We did so to teach Basque to Llama models with promising results!

Interestingly, you only need English instructions and target language corpora 🤯

1/3

Reposted by Oscar Sainz

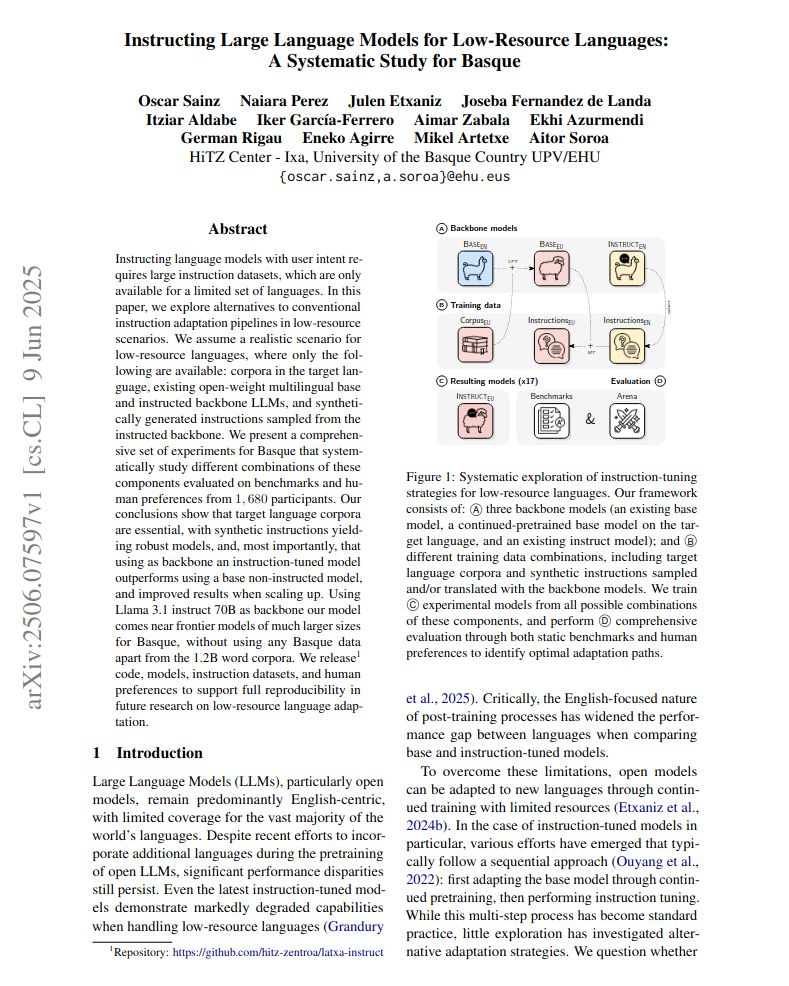

[1/7]

#newHitzPaper

Many languages are underserved by open LLMs, and face the following question: Which is the best way to produce open instruction-tuned LLMs for low-resource languages?

We obtained great results for a cost-effective option!

📄Paper: arxiv.org/abs/2506.07597

#newHitzPaper

Many languages are underserved by open LLMs, and face the following question: Which is the best way to produce open instruction-tuned LLMs for low-resource languages?

We obtained great results for a cost-effective option!

📄Paper: arxiv.org/abs/2506.07597

June 11, 2025 at 10:27 AM

[1/7]

#newHitzPaper

Many languages are underserved by open LLMs, and face the following question: Which is the best way to produce open instruction-tuned LLMs for low-resource languages?

We obtained great results for a cost-effective option!

📄Paper: arxiv.org/abs/2506.07597

#newHitzPaper

Many languages are underserved by open LLMs, and face the following question: Which is the best way to produce open instruction-tuned LLMs for low-resource languages?

We obtained great results for a cost-effective option!

📄Paper: arxiv.org/abs/2506.07597