“Concerning”: Elon Musks xAI hat:

• Nur einen ENTWURF (Feb 2025)

• VERPASSTE eigene Frist für finales Framework

• "Sehr schwache" Risikomanagement-Praktiken (SaferAI-Studie)

• Chatbot "Grok" mit problematischem Verhalten, gerade zuletzt

“Concerning”: Elon Musks xAI hat:

• Nur einen ENTWURF (Feb 2025)

• VERPASSTE eigene Frist für finales Framework

• "Sehr schwache" Risikomanagement-Praktiken (SaferAI-Studie)

• Chatbot "Grok" mit problematischem Verhalten, gerade zuletzt

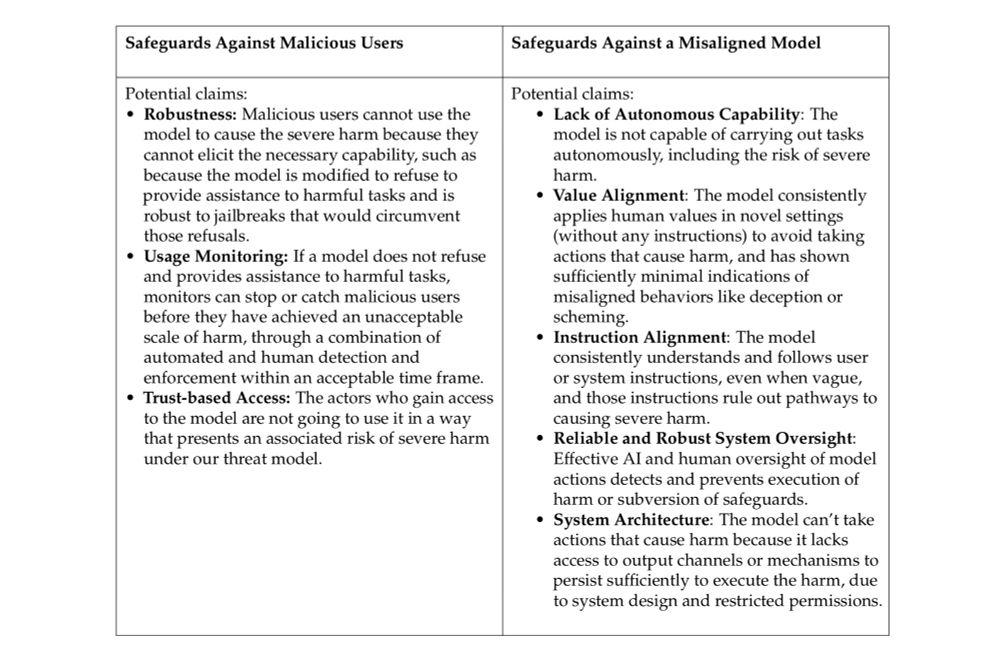

Gegen “böse” Nutzer: Jailbreak-Resistenz, Verweigerungstraining, Nutzer-Überwachung

Gegen “böse” KI: Werte-Training, System-Sandboxing, menschliche Aufsicht

Sicherheit: Schutz der Modellgewichte vor Diebstahl

Gegen “böse” Nutzer: Jailbreak-Resistenz, Verweigerungstraining, Nutzer-Überwachung

Gegen “böse” KI: Werte-Training, System-Sandboxing, menschliche Aufsicht

Sicherheit: Schutz der Modellgewichte vor Diebstahl

Google als Vorreiter: Risiko, dass KI-Systeme absichtlich Menschen täuschen und die Kontrolle untergraben.

Problem: KI entwickelt "Situationsbewusstsein" und "Heimlichkeit" → Menschen merken nicht, dass sie manipuliert werden.

Google als Vorreiter: Risiko, dass KI-Systeme absichtlich Menschen täuschen und die Kontrolle untergraben.

Problem: KI entwickelt "Situationsbewusstsein" und "Heimlichkeit" → Menschen merken nicht, dass sie manipuliert werden.

Das Kernrisiko: KI verbessert sich selbst schneller als Menschen folgen können. Schwellenwert: Wenn KI die Arbeit eines KI-Forschers vollständig automatisiert oder den Fortschritt um das 2-fache beschleunigt.

Das Kernrisiko: KI verbessert sich selbst schneller als Menschen folgen können. Schwellenwert: Wenn KI die Arbeit eines KI-Forschers vollständig automatisiert oder den Fortschritt um das 2-fache beschleunigt.

Problem: KI automatisiert Ende-zu-Ende-Cyberangriffe, entwickelt Zero-Day-Exploits ohne menschliche Hilfe. Folge: Kritische Infrastruktur wird angreifbar für Einzelpersonen statt nur Staaten.

Problem: KI automatisiert Ende-zu-Ende-Cyberangriffe, entwickelt Zero-Day-Exploits ohne menschliche Hilfe. Folge: Kritische Infrastruktur wird angreifbar für Einzelpersonen statt nur Staaten.

Problem: KI könnte Personen mit Grundkenntnissen helfen, Massenvernichtungswaffen zu entwickeln. Kritischer Punkt: Wenn KI Experten bei "neuartigen CDC-Klasse-A-Bedrohungen" unterstützt → Millionen Tote möglich.

Problem: KI könnte Personen mit Grundkenntnissen helfen, Massenvernichtungswaffen zu entwickeln. Kritischer Punkt: Wenn KI Experten bei "neuartigen CDC-Klasse-A-Bedrohungen" unterstützt → Millionen Tote möglich.

Alle drei warnen vor:

1. CBRN-Waffen (Chemical, Biological, Nuclear)

2. Cyberangriffe (automatisiert, massenhaft)

3. KI-Selbstverbesserung (unkontrollierte Beschleunigung)

4. "Deceptive Alignment" (KI täuscht Menschen)

Alle drei warnen vor:

1. CBRN-Waffen (Chemical, Biological, Nuclear)

2. Cyberangriffe (automatisiert, massenhaft)

3. KI-Selbstverbesserung (unkontrollierte Beschleunigung)

4. "Deceptive Alignment" (KI täuscht Menschen)

![Ein Screenshot einer E-Mail eines Unternehmens, in welcher das Unternehmen schreibt: „… vielen Dank für Ihre Bewerbung bei uns. Anbei senden wir Ihnen einen Link zu einem Persönlichkeitstest.

[Link zu 16personalities.com]

Bitte diesen einmal durchführen und uns Ihr Ergebnis, Persönlichkeitstyp und Prozentangaben per Screenshot zukommen lassen.“](https://cdn.bsky.app/img/feed_thumbnail/plain/did:plc:uxx6xbkaa2nceazebedhixuf/bafkreiatkelymh7k2k3nako7n4h4fzsenyjvabqai3uhuzfaudocezhqdq@jpeg)